Es ist schon fast zwei Jahre her: KI-Bildgeneratoren wie Midjourney und DALL-E wurden der breiten Öffentlichkeit vorgestellt, im März 2023 folgte Adobe Firefly – eine neue Ära der Bilderstellung wurde eingeläutet. Exemplarisch haben wir uns die Neuerungen bei den drei Bildgeneratoren angesehen und uns anhand von Beispielen aus der Produkt- und Werbewelt Gedanken über die Zukunft der Fotografie gemacht.

KI-Bildgenerierung 2024: Status Quo

In der dynamischen Welt der KI-Bildgeneratoren befinden wir uns an einem bemerkenswerten Wendepunkt. Innovative Technologien wie DALL-E, Midjourney und Adobe Firefly revolutionieren die Art und Weise, wie wir kreativ tätig sind, und öffnen die Tür zu einer Ära, in der die Grenzen zwischen menschlicher Kunstfertigkeit und maschineller Präzision verschwimmen.

Diese Bildgeneratoren, ausgestattet mit der Fähigkeit, aus Textbeschreibungen (den sogenannten Prompts) eindrucksvolle visuelle Inhalte zu erstellen, erweitern das kreative Spektrum und stellen gleichzeitig neue Fragen zu Originalität und Ethik in der digitalen Kunstwelt.

Erinnert Sie diese Geschichte auch an etwas anderes? Möglicherweise an die Furore, die zum Beispiel die ersten Digitalkameras und die digitale Bildbearbeitung mit Adobe Photoshop in den 90er-Jahren des vergangenen Jahrhunderts ausgelöst haben.

Während Chatbots wie ChatGPT mit den Frage- und Aufgabenstellungen auf Deutsch sehr gut klarkommen, ist die Eingabe von Prompts bei manchen KI-Bildgeneratoren auf Englisch zu empfehlen. Midjourney z. B. arbeitet nur mit Befehlen auf Englisch.

Wenn Sie sich bei der ausführlichen Formulierung unsicher fühlen, können Sie Übersetzungstools wie DeepL (www.deepl.com/translator) nutzen. Adobe Firefly funktioniert ganz gut auf Deutsch (und noch vielen anderen Sprachen), es lohnt sich aber, sich die Bildergebnisse auch von Prompts auf Englisch anzusehen.

Ständig erweitert

Die KI-gesteuerten Bildgeneratoren sind heute nicht mehr aus unserem Alltag wegzudenken. Laut einer Statistik der Plattform FlexOS ist Bildgenerierung mit 11 Prozent einer der meistgesuchten Themenbereiche nach Schreiben („Writing & Editing“), Lernen („Education“) und Kommunizieren („Social & Characters“)*.

Dabei hatte Midjourney, einer der weltweit beliebtesten KIBildgeneratoren, von September 2022 bis August 2023 etwa 500,4 Millionen Aufrufe, was 2,1 Prozent des gesamten KI-Nutzungstraffics überhaupt ausmacht**. Beim Adobe Summit 2024 Ende März wurde vom Software-Hersteller berichtet, dass bis dato (nur ein Jahr nach der Veröffentlichung von Adobe Firefly) die Nutzerinnen und Nutzer des hauseigenen Bildgenerators mehr als 6,5 Milliarden KI-Bilder erzeugt haben.

Um sich im Ozean des schnell und ständig wachsenden KI-Feldes hervorzuheben, sind die Macherinnen und Macher dahinter stets bemüht, ihr Angebot zu optimieren. Es werden immer neue Funktionen und Erweiterungen hinzugefügt, die die Nutzung der KI-Bildgeneratoren bedienungsfreundlicher und die Ergebnisse präziser machen (sollten).

So wurden in diesem Jahr in Midjourney 6 unter anderem gleich zwei große Features eingeführt – „Consistent Styles“ (Parameter --sref für „Style Reference“) und „Consistent Characters“ (Parameter --cref für „Character Reference“). Mit der ersten Funktion können Sie Bilder als Stilreferenzen in Ihrem Prompt verwenden, um den Stil oder die Ästhetik der Werke zu beeinflussen, die Sie von Midjourney erstellen lassen möchten.

Funktion zwei wird von vielen auch als die bislang wichtigste Neuerung beim Bildgenerator bezeichnet. Es ermöglicht, eine Charakterabbildung zu erstellen und diese als Charakterreferenz im Prompt anzuwenden, um Bilder desselben Charakters in verschiedenen Situationen zu generieren (s. Kasten auf S. 55).

Eine bahnbrechende Verbesserung! Die Fortsetzung dieser an den Nutzerbedürfnissen angepassten Funktionen soll in den kommenden Monaten und der Version 7 verfeinert werden, kündigte Midjourney- Gründer David Holz Mitte März an. Mit der neuen Personalisierungsfunktion werden KI-Bildergebnisse auch anhand der Likeund Galerie-Historie der einzelnen Nutzenden generiert. Bis Ende 2024 möchte Midjourney zudem ein eigenes 3D- und Video-Modell herausbringen.

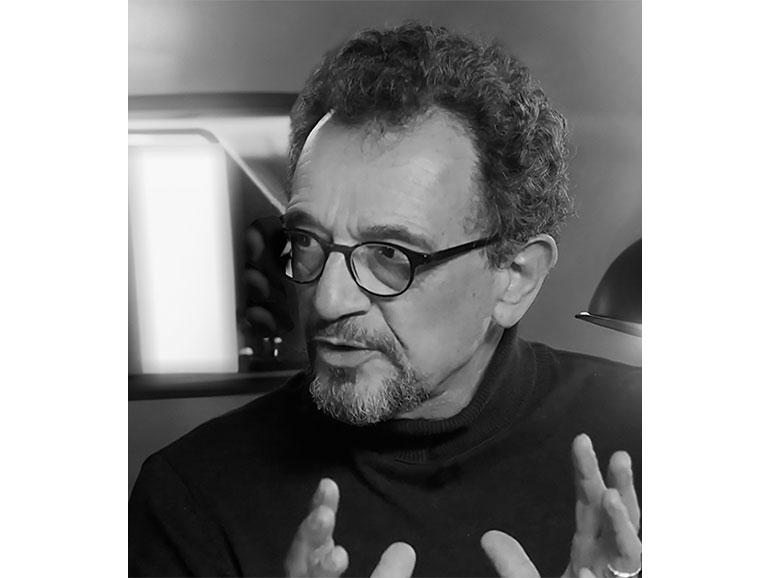

Landschaftsfotograf Adrian Rohnfelder ist begeisterter KI-Nutzer der ersten Stunde. Zusammen mit seinem Kollegen Andreas Jürgensen betreibt er die Plattform AI Imagelab, auf der sie über Neues aus der Bild-, Video- und Musik-KI-Welt berichten und Tipps geben.

Adrian Rohnfelder bezeichnet sich selbst als Bildermacher. Um seine vielen abenteuerlichen Ideen umzusetzen, hat er bis jetzt seine Kamera in Kombination mit Photoshop & Co. benutzt. „Die KI gibt mir einfach eine andere Möglichkeit, die Bilder, die ich nicht fotografieren kann oder momentan nicht fotografieren möchte, endlich auch zu realisieren“, so der Kreative.

„Wenn ich Bilder mache, habe ich die erlebten Fotos, wie auch die KI-generierten Bilder. Aber die Geschichten, die ich im Kopf habe, die versuche ich, mit beiden Welten – je nachdem, welches Medium gerade passt – zu erzielen.“

So kombiniert Adrian seine Fotos mit neu generierten Objekten, nutzt die eigenen Aufnahmen als Referenz für künstlich erstellte Welten, um seinen eigenen Stil neu zu interpretieren. „Es ist erstaunlich, wie schnell Midjourney, mein persönlicher Favorit unter den KI-Bildgeneratoren, von einem absoluten Spielzeug zu einem ernst zu nehmenden Tool gereift ist“, fügt der Bildermacher hinzu.

„Für mich als Nutzer ist es toll, ein richtiges Werkzeug an der Hand zu haben, bei dem die Ergebnisse nicht mehr à la ‚Lassen wir uns überraschen‘ sind, sondern es kontrolliert steuern kann.“ Aufgrund der großen Zugänglichkeit am Computer oder per App sowie der relativ einfach zu bedienenden Funktionen und somit der verkürzten Produktionszeit glaubt Adrian, dass in Zukunft ein Großteil der Bilder und Videos mit KI generiert wird.

„Jetzt kommt jedoch das große Aber: Wenn du hochqualitative Werke erstellen möchtest, wirst du auch weiterhin fotografisches Knowhow brauchen. Wenn ich an Agenturen, größere Projekte und Werbung für bekannte Marken denke, werden immer noch Leute gebraucht, die die KI-Tools beherrschen.

Du wirst nicht unbedingt fotografieren, sondern generieren, dafür brauchst du aber meistens mehrere Versuche, Verständnis für Bildkomposition, Lichtsetzung, Farben und überhaupt gute Ideen. Du wirst eventuell mehrere Tools kombinieren, doch noch feine Korrekturen in Photoshop vornehmen. Für gute Qualität werden wir Fusionslösungen haben müssen.“

Schneller zum Bildergebnis

Kurz vor Redaktionsschluss hat auch OpenAI drei große Neuerungen beim firmeneigenen Bildgenerator DALL-E 3 präsentiert. Es gibt nun direkt neben der Texteingabeleiste verschiedene Auswahlknöpfe: Mit „Aspect Ratio“ wählen Sie automatisch das Bildformat („Square“ für Quadrat, „Widescreen“ für 16:9 und „Vertical“) aus.

Die Punkte über der Leiste bieten neue, spannende Bildstil-Optionen mit Vorschau des Looks an. So sparen Sie sich die manuelle Eingabe dieser Parameter in Ihrem Prompt. Die dritte Neuigkeit erreichen Sie, nachdem Sie Ihre Bilder generiert und eine Version angeklickt haben: Oben rechts im Vorschaufenster finden Sie den Knopf „Select“.

Sobald ausgewählt, können Sie mit der Maus ein Objekt oder einen ganzen Bildbereich markieren und in die Textbox unten rechts Ihren Änderungswunsch eintippen. Auf diese Weise verändern Sie nur diese bestimmte Stelle, ohne Ihr generiertes Bild zu verlieren. Bereits angekündigt wurde auch Sora, der KI-Videogenerator von OpenAI, der bis jetzt nur von einigen wenigen Kreativen getestet wurde.

Auch im Hause Adobe wird hinter den Kulissen weiter getüftelt. Beim eben erwähnten Event Ende März kündigte der Hersteller einige neue Funktionen seines KI-Bildgenerators Adobe Firefly an. Mit der Struktur-Referenz können Sie die Struktur eines bestehenden Bildes (Ihres eigenen oder eines aus der KI-Datenbank) auf einfache Weise auf neu generierte Bilder anwenden.

Dies soll das mühsame Ausprobieren der perfekten Eingabeaufforderung erleichtern, um die gewünschte Ausgabe zu erhalten. Durch die Kombination der Struktur-Referenz mit der Stile-Referenz von Adobe Firefly, einer weiteren Funktion im Modul „Text zu Bild“, können Sie sowohl die Struktur als auch den Bildlook eines Werkes referenzieren, um Ihre Ideen schnell zum Leben zu erwecken.

Beides ist, wie üblich für diesen KI-Bildgenerator, per Auswahlpunkt im Menü links anwählbar, und soll laut Hersteller den Zufallsfaktor bei der Bildgenerierung reduzieren. Adobe gab außerdem die sogenannten „Custom Models“ für Firefly bekannt, die ein individuelles Training des KI-Modells für die eigene Corporate-Design-Sprache wie Objekte, Hintergründe und Stile ermöglichen sollen.

Laut Adobe seien zehn bis 20 Trainingsbilder für gute Ergebnisse vollkommen ausreichend. Strenge Governance- und Sicherheitskontrollen sollen außerdem sicherstellen, dass die Inhalte, Daten und Arbeitsabläufe einer Marke innerhalb des Unternehmens bleiben.

Der im Februar eingeführten Funktion „Consistent Styles“ folgte Anfang März die nächste wichtige Neuerung beim beliebten Bildgenerator: „Consistent Characters“.

Die Erstellung von „Consistent Characters“ mit Midjourney, also konsistenten Charakteren innerhalb Ihrer visuellen Projekte, basiert auf dem Prinzip, einen einheitlichen Charakter oder eine Gruppe von Charakteren über mehrere Bilder hinweg beizubehalten.

Auf diese Weise generieren Sie schnell und einfach eine Art realistische Bilderserie, die Sie für Storyboards benutzen können. Im Folgenden zeigen wir Ihnen, wie das funktioniert:

1 | Wie bei allen Bildgeneratoren beginnen Sie auch hier mit dem Charakterentwurf.

Skizzieren Sie hierfür eine detaillierte Beschreibung der gewünschten Person, einschließlich physischer Merkmale wie Geschlecht, Alter, Körpergröße, Stil, Kleidung und Haltung.

2 | Nutzen Sie nun Ihre Beschreibung, um einen genauen Prompt zu erstellen. Integrieren Sie spezifische Details, die Sie in Ihrem Charakter konsistent halten möchten.

Passen Sie, falls nötig, Ihren Prompt so lange an, bis Sie mit dem Ergebnis zufrieden sind (s. unser großes hochformatiges Bild oben).

3 | Per Rechtsklick auf das fertige Bild wählen Sie „Bildadresse kopieren“. Erstellen Sie jetzt einen neuen Prompt, der darstellt, was der Charakter tun soll.

Fügen Sie den Parameter --cref und die kopierte Bildadresse/URL hinzu („cref“ steht für „Character reference“). Ein Tipp zum letzten Schritt von Sina Dallmann, Performance- und Conversion-Kolleg*in aus unserem Verlag: Stellen Sie am Ende des Prompts auch die Gewichtung ein, wie stark Midjourney der Referenz folgen soll.

Der Parameter dafür ist --cw und funktioniert mit jedem Wert zwischen 0 und 100. --cw 100 ist die Standardeinstellung und berücksichtigt das Gesicht, die Haare und die Kleidung, während Stärke 0 (--cw 0) sich nur auf das Gesicht konzentriert.

„KI-generierte Bilder sind letztendlich auch nur eine weitere Möglichkeit, zu Abbildungen zu kommen. Die Frage, die sich daraus ergibt, ist doch, welche Positionierung dazu eingenommen wird und wie Fotografierende ihre Arbeit definieren. Es ist keinesfalls so, dass die rein fotografische Arbeit nicht mehr gefragt ist.

Ganz im Gegenteil: Auch wenn bestimmte Aufgaben durch KI erledigt werden können, die pure Fotografie steht immer noch für Authentizität und für die von der durch die Schaffenden getragenen, persönlichen Arbeitsweise.

Das, was in den letzten Jahren durch die vielfältigen Möglichkeiten der digitalen Bilderstellung entstanden ist und nun zu großen Befürchtungen führt, ist ursprünglich nicht in der Technik der Bildgenerierung zu suchen, sondern in der Intention und der mangelnden, auf Persönlichkeit ausgerichteten Umsetzung.

Wer bisher glaubte, Bilder können schlicht digital so verändert oder generiert werden, dass dadurch ein individuelles Werk entsteht, der wird inzwischen mit der auf diese Art produzierten Beliebigkeit solcher Bilder konfrontiert. So liegt es nicht an der Technik, die Probleme bereitet, sondern an der mangelnden Relevanz der Arbeiten, zumindest im kommerziellen und anspruchsvollen künstlerischen Bereich.

Früher, zu analogen Zeiten, ging es bei den Profis um das fotografische Handwerk, um Großformatfotografie, die die breite Masse nicht beherrschen konnte. Seit den 90er-Jahren und der Einführung der Digitalkameras hat sich das deutlich gewandelt. Jede und jeder kann heute ein Foto machen und es nachträglich optimieren. Das Beherrschen der Technik ist keine Legitimation mehr, sich Fotografin oder Fotograf zu nennen.

Es kommt immer auf die Idee, die Kreativität, auf die persönliche Philosophie an, wie wir etwas sehen und fotografieren. Genau das wird auch von den Kundinnen und Kunden gewünscht. Mit der KI-Bildgenerierung werden ihnen die Individualität und Authentizität sogar noch wichtiger, damit sich ihre Produkte von der Maße abheben können.

Es liegt an den Fotografierenden, sich so zu positionieren, dass die Klientinnen und Klienten ihre Besonderheiten erkennen und dafür Geld bezahlen. Es ist schwer, aber so war es immer in diesem Beruf.“

„Bei falkemedia streben wir stets danach, neueste Technologien zu nutzen und Branchentrends zu setzen. Wir sind tatsächlich an einem Punkt, an dem traditionelle Fotografie auf die neuesten KI-Innovationen trifft – eine Mischung, die nicht nur spannend ist, sondern auch unsere Kolleginnen und Kollegen herausfordert, da unendliche neue Möglichkeiten eröffnet werden.

In unserem täglichen Kreativworkflow sind KIgestützte Techniken integriert und in der digitalen Bildbearbeitung KI-basierte Routinen wie Hintergrundentfernung, Upscaling Out- und Inpainting schon fest verankert. Mit ihrer Hilfe stoßen wir die kreativen Türen weit auf und steigern unsere Prozesseffizienz deutlich, sodass wir mehr Freiheiten haben, Mehrwert für unsere Kundinnen und Kunden zu kreieren.

Trotz des aufregenden Potenzials von KI bleibt der menschliche Einfluss in unserem Schaffensprozess unverzichtbar. Jedes von KI interpolierte Bild wird vom Team kuratiert, genau geprüft und überarbeitet, um sicherzustellen, dass Qualität und Kundenerlebnis immer an erster Stelle stehen.

Unser nächstes Ziel ist es, durch den Einsatz von KI aus unseren umfangreichen hauseigenen Bildarchiven maßgeschneiderte Bilder zu generieren. Wir gehen diese Herausforderung mit einer Mischung aus Neugier und Sorgfalt an, denn in der Food- Fotografie zählt jede Komponente für ein realistisches Endergebnis.

Deshalb setzen wir aktuell bei unseren hochwertigen Druckprodukten und umfangreichen Kampagnen nach wie vor auf echte Fotografie. Wir sind jedoch optimistisch, dass die KI schon bald auch unsere strengen Anforderungen erfüllen und ein integraler Bestandteil unserer Weiterentwicklung sein wird.“

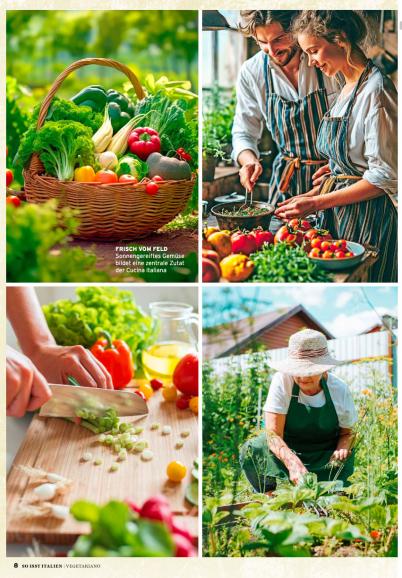

„Es gibt Fotos im Foodkontext, die sehr generisch sind. Ein Strauch Basilikum oder ein Hefeteig sind für eine KI kein Problem, weil es Tausende Beispiele gibt, aus denen sich die immer gleiche Information zusammensetzen, was genau diese beiden Dinge ausmacht.

Daher lässt sich so ein Motiv heute schon gut individualisieren – zum Beispiel Hefeteig in einer roten Schüssel auf einem Tisch im Garten oder mehrere Basilikum-Töpfe auf einem Esstisch. Beides wird man so konkret länger in einer Bilddatenbank suchen müssen und vielleicht nie finden.

Da kann man schon mal die KI beauftragen. Schwieriger wird es, wenn Kreationen optisch dargestellt werden sollen, die es so kein zweites Mal gibt, wie ein Gericht, das aus einer absolut neuen Kombination aus Zutaten und anders als gewöhnlich zusammengesetzt ist – dafür gibt es dann online nicht viele vergleichbare Informationen, also kann das Ergebnis sehr schwankend oder auch fehlerhaft ausfallen. Da ist es aktuell noch einfacher, eine solche Kreationen neu zu shooten.“

Eine Frage der Sicherheit

Aber was ist mit dem Datenschutz bei Referenzbildern, vor allem bei neuen Produkten, für die neue Werbebilder mithilfe der KI erstellt werden? Auf welchen Servern werden diese gesichert, wer wird sich daran bedienen, wo werden sie noch ausgespielt oder als Trainingsdaten verwendet?

Davor warnt auch Storyteller Adrian Rohnfelder: „Stellen wir uns eine große Autofirma vor, die ein neues Modell einführen möchte. Es wäre wahnsinnig, Bilder vom neuen Produkt als Referenz etwa bei Midjourney hochzuladen.

Diese landen irgendwo auf Servern in den USA, wo ganz andere Gesetze gelten. Wo sie ab dann noch zu sehen sein werden, wissen wir gar nicht.“ Bei solchen Fällen sei es besser, die komplette Bildgenerierung bei sich im Haus zu machen und die Daten auf lokalen Rechnern zu sichern.

*www.flexos.work/learn/generative-ai-top-150

**www.visualcapitalist.com/ranked-the-most-popular-ai-tools/

Recherchestand: 08.04.2024