Willkommen im KI-Zeitalter! Die Technologien gibt es zwar schon lange, jetzt sind sie aber für alle zugänglich. Was bedeutet das für die Bildproduktion, was können wir gegen gefälschte, KI-generierte Inhalte tun und wie gehen (Kamera-)Hersteller damit um? Wir verschaffen einen Überblick.

KI-Fakes vs. echte Fotos

Bildmanipulationen und -composings gibt es bereits seit Jahrzehnten. Selbst zu Foto-analogen Zeiten wurde manipuliert. Nur wurden und werden die Bildbearbeitungstechniken nicht nur für kreative künstlerische Zwecke der Unterhaltung benutzt.

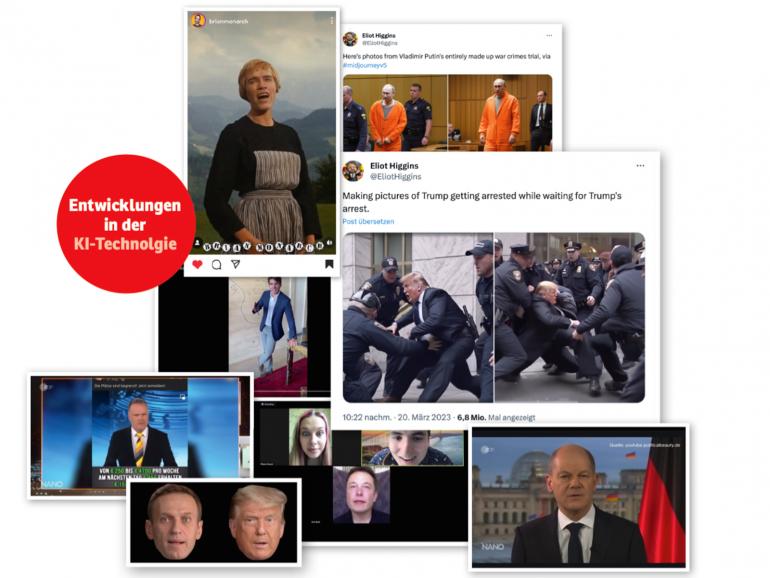

Beispiele für die Verbreitung gefälschter Bild- und Videoinhalte mit dem Ziel Meinungsbeeinflussung bei Wahlkampagnen, Desinformation bei Kriegsführungen oder Bloßstellung von berühmten oder aber auch von Privatpersonen gibt es mittlerweile leider mehr als genug.

Sie erinnern sich vielleicht an die angebliche Kapitulationsrede des ukrainischen Präsidenten Wolodymyr Selenskyj, die bereits im März 2022 bei dem ukrainischen Fernsehsender U24 und auf Facebook von Hackerinnen und Hackern gezeigt wurde. Oder an die KI-generierten pornografischen Bilder des US-amerikanischen Stars Taylor Swift, die im Januar dieses Jahres online eine enorme Welle geschlagen haben.

Schnell wurden sie registriert und entfernt. Dennoch wurde einer dieser Inhalte allein auf der Plattform X in der Zeit 47 Millionen Mal angesehen. Bei uns sorgte Ende letzten Jahres ein Fake-Video für Staunen, in dem Bundeskanzler Olaf Scholz das Verbot der AfD ankündigte. Es wurde von der Politgruppe „Zentrum für politische Schönheit“ als Demonstration gegen die Partei erstellt, stellt aber gut dar, was alles im Bereich Deepfake möglich ist.

Im Kampf gegen die Verbreitung von gefälschten Bildern und Videos, den so genannten Deepfakes, arbeitet man seit Jahren an verschiedenen Fronten daran, wie solche Inhalte für News-Redaktionen sowie für die breite Masse schnell als unecht abzulesen sind. Hier stellen wir Ihnen drei Ansätze solcher Bemühungen vor.

1 | Die Kamerahersteller

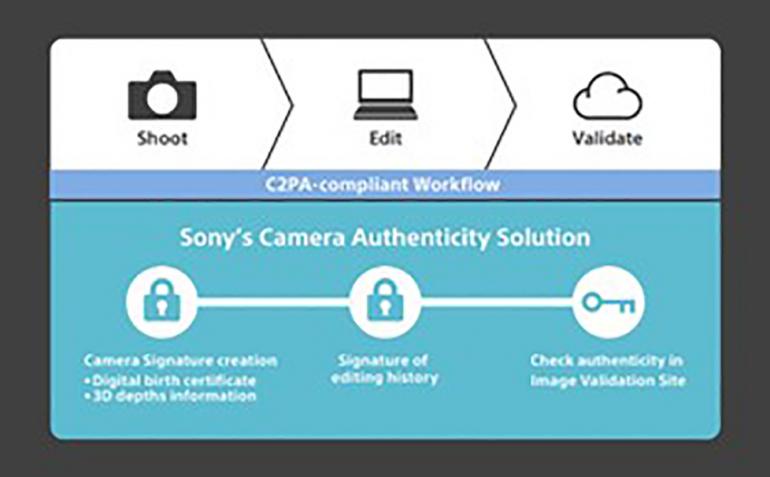

2019 wurde die Content Authenticity Initiative (CAI), eine branchenübergreifende Kooperation, von Adobe, Twitter (heute X) und der New York Times mit dem Ziel gegründet, Tools und Standards bereitzustellen, um die Authentizität und Herkunft digitaler, darunter auch KI-generierter, Beiträge zu verifizieren.

Dadurch soll das Vertrauen der Öffentlichkeit in die Inhaltserstellung bewahrt werden. Durch die Integration von Technologien wie Kryptografie und Blockchain soll die Echtheit der verschiedenen journalistischen Medieninhalte jederzeit überprüft werden können.

Mittlerweile haben sich über 2000 Medien- und Techunternehmen der CAI angeschlossen. Seit 2022 gehören die großen Kamerahersteller Nikon, Leica, Canon und Sony, seit Mai 2024 auch Fujifilm dazu.

Zusammen arbeiten sie daran, die Transparenz bei digitalen Bildern und Videos zu fördern und die Verbreitung von Falschinformationen zu unterbrechen. Die Spezifikationen werden immer weiter verfeinert und so kam im Januar 2024 bereits die erste Kamera, die Leica M11-P, die mit der Echtheitszertifikat-Technologie ausgestattet ist, heraus.

Im März und April folgten die Firmware-Updates für die Sony-Modelle Alpha 1, Alpha 7S III, Alpha 7 IV und Alpha 9 III, die die Camera Authenticity Solution, die kamerainterne digitale Signatur und die Unterstützung des C2PA-Formats beinhalten. An Letzterem können Verlage, Urheberinnen und Verbraucher die Authentizität und Herkunft verschiedener Medientypen erkennen.

https://contentauthenticity.org

2 | Die Smartphone-Hersteller

Ende Juni dieses Jahres kündigte das chinesische Techunternehmen Honor in Shanghai als Erster eine wichtige KI-Innovation für mobile Geräte an – die AI Deepfake Detection (auf Deutsch: KI-Deepfake-Erkennung).

Um Betrug zu verhindern und digital manipulierte Inhalte zu erkennen, soll die Funktion Bild für Bild Informationen wie Augenkontakt, Beleuchtung, Bildklarheit und Videowiedergabe untersuchen, um für das menschliche Auge nicht wahrnehmbare Fehler zu identifizieren.

Diese KI-Deepfake-Erkennung wurde anhand eines großen Datensatzes von Videos und Bildern, die mit Onlinebetrug in Verbindung stehen, trainiert. Dies soll der KI ermöglichen, innerhalb von drei Sekunden Identifikation, Screening und Vergleich durchzuführen, so der Hersteller.

Wenn synthetischer oder veränderter Inhalt erkannt wird, wird sofort eine Risikowarnung an den Nutzenden ausgegeben, um ihre Sicherheit zu gewährleisten.

3 | Die Social-Media-Plattformen

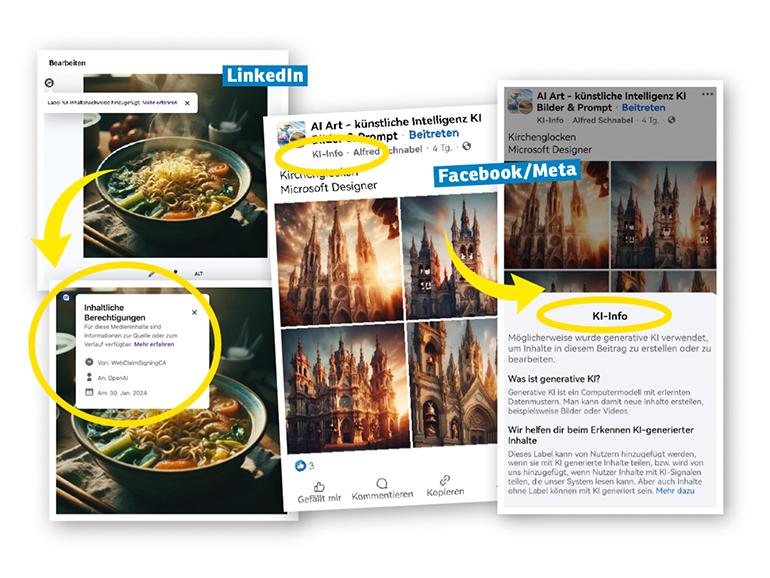

Auch viele Social-Media-Plattformen lassen nach und nach die bei ihnen hochgeladenen Bild- und Videoinhalte als „KI-Info“ kennzeichnen. Nach YouTube, TikTok und Meta (Facebook, Instagram, s. Bilder ganz rechts) stellte auch LinkedIn Mitte Mai die Nutzung des C2PA-Standards vor.

So werden die Plattform-Mitglieder das neue Symbol „Cr“ sehen (s. rechts), das ihnen hilft, den Ursprung von KI-erstellten Medien nachzuverfolgen, einschließlich der Quelle und der Historie der Inhalte sowie der Information, ob sie von KI erstellt oder bearbeitet wurden, so Patrick Corrigan, Vizepräsident der LinkedIn-Rechtsabteilung.

Während aber bei Facebook z. B. die Markierung der Bilder sowohl von der Plattform als auch von den Nutzenden manuell erstellt werden kann, erfolgt diese bei LinkedIn nur automatisch (und dementsprechend nicht immer).

Man kann nur hoffen, dass die hausinterne KI dem KI-generierten Content auf die Spur kommt. Bis jetzt klappt es allerdings nur bei Inhalten, die mit DALL-E und Adobe Firefly erstellt worden sind.

Fakes erkennen, aber wie?

Bei der Frage, wie sich KI-generierte Bilder oder Videos heutzutage identifizieren lassen, gibt es leider keine eindeutigen Regeln. Dennoch können Sie dabei auf ein paar Einzelheiten achten, beispielsweise auf ungewöhnliche Details wie asymmetrische Gesichter, seltsam geformte Zähne oder Finger, unnatürliche Augenstellungen, unterschiedliche Augenfarben, unscharfe Ränder oder unregelmäßige Lichtverhältnisse.

KI-Generatoren haben häufig (noch) Schwierigkeiten, diese Elemente korrekt darzustellen. Eine andere Möglichkeit ist die Untersuchung der Metadaten, falls vorhanden natürlich. Manche Tools hinterlassen Hinweise darauf, dass ein Medieninhalt mit einer bestimmter Software oder KI-Technologie erstellt wurde. Darüber hinaus können Sie die Quelle des Bildes oder Videos überprüfen.

Wenn es von einer wenig bekannten oder unzuverlässigen Quelle stammt, könnte es sich um einen KI-generierten Falsch-Inhalt handeln. Auch ein Mangel an Kontext oder eine ungewöhnlich hohe Bildqualität können Indizien sein. Anders bei synthetisch erstellten Videos: Ist die Bildqualität sehr schlecht, kann es sein, dass Sie einen Deepfake sehen. Dabei sind oft auch Fehler bei der Aussprache eines Vokals oder einzelner Wörter erkennbar sowie asynchrone Bewegungen der Lippen zum gesprochenen Text.

Und trotzdem …

In einer im März 2024 veröffentlichten Studie der kanadischen Waterloo University wurde festgestellt, dass nur 61 Prozent der insgesamt 260 Testpersonen zwischen KIgenerierten und echten Menschenporträts unterscheiden konnten. Für den Test wurden ihnen zehn zufällig ausgewählte Fotografien aus der Google-Suche und zehn mit den KI-Bildgeneratoren Stable Diffusion und DALL-E synthetisch erstellte Bilder gezeigt.

Dabei hatten die Teilnehmenden genügend Zeit, um sich Details wie Finger, Zähne usw. in den Bildern anzusehen. Was nehmen wir aber als echt wahr, wenn wir in Social Media schnell herumscrollen, rasch zwischen den Inhalten wechseln, ohne uns darin zu vertiefen? Sind wir überhaupt noch in der Lage, zwischen Fake und Echt zu unterscheiden?

Genau wie die Bildbearbeitung sind Desinformation und Massentäuschung nichts Neues. Doch die Werkzeuge dafür entwickeln sich immer schneller. Die meisten Menschen kommen nicht mehr hinterher und dies führt zu großen Spaltungen und Konfrontationen in der Gesellschaft.

In Zukunft wird es sogar immer schwieriger, Echtes von Fälschungen zu unterscheiden, unabhängig davon, wie gut wir unsere Augen trainieren. Deshalb ist es besonders wichtig, parallel zur vielseitigen Verbreitung der KI-Tools auch Technik zu entwickeln, die Deepfakes sofort identifiziert, davor warnt und dagegen vorgeht.

Eine Möglichkeit, gefälschte und manipulierte Inhalte als solche zu entlarven und dagegen vorzugehen, bieten spezialisierte Softwares oder Online-Tools. Hier stellen wir Ihnen einige davon vor.

Mithilfe forensischer Analysen werden Bilder und visuelle Medien untersucht, wodurch ihre Authentizität überprüft sowie digitale Manipulationen aufdeckt werden können.

Dafür werden spezialisierte Softwares benutzt. Im Internet finden Sie Websites wie Fotoforensics (https://fotoforensics.com), Forensically (https://29a.ch/photo-forensics) und Illuminarty (https://app.illuminarty.ai/#/image) für die kostenfreie Bildanalyse, oder Deepware Scanner AI (https://scanner.deepware.ai) für die Videoerkennung (mit einer Filmlänge von bis zu 10 Minuten).

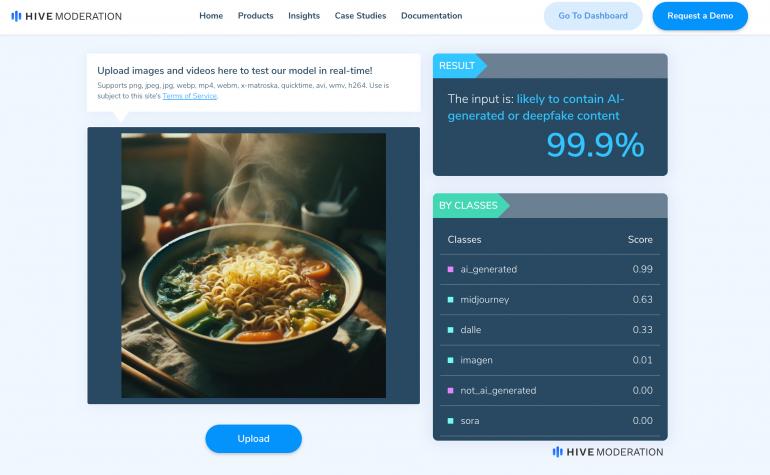

Bei Reality Defender (www.realitydefender.com) und Sensity AI (https://sensity.ai) müssen Sie die Nutzung des Erkennungstools erfragen, indem Sie Ihren Namen, Firmennamen und -adresse sowie den Nutzungszweck eingeben. Bei Hive Moderation (https://hivemoderation.com/ai-generated-content-detection) können Sie ebenfalls ohne jegliche Kosten online überprüfen, ob ein Video oder Bild KI-generiert worden ist.

Dazu bietet das Unternehmen auch die Hive AI Detector Chrome Extension, die Sie in Ihren Google-Chrome-Internetbrowser integrieren können, sodass Sie bei jeder geöffneten Website Bild- und Textmaterial auf Echtheit prüfen lassen können.

Darüber hinaus kann die KI-Erkennungs-Technologie auf der eigenen Website implementiert werden, um schnell Informationen zu bekommen, ob andere z. B. in Chats synthetisch erstellte Inhalte hochgeladen haben, und so seine Community zu schützen.

Allerdings ist es wichtig, zu beachten, dass solche Online-Angebote nicht die tiefgründige Analyse einer im Bereich ausgebildeten Person mit Arbeitserfahrung (Forensikerin bzw. Forensiker) und eine leistungsstarke Spezialsoftware ersetzen können. Das Fraunhofer-Institut für Sichere Informationstechnologie (www.sit.fraunhofer.de) beispielsweise forscht seit langem professionell in diesem Gebiet.

Die Politik ist gefragt

Wenn es um den Schutz der Gesellschaft gegen Deepfakes und die dadurch weiterführenden Schäden geht, brauchen wir strenge Regularien. Zwar versprechen Techunternehmen, die die KI-Technologien auf den Markt bringen, und Online- Plattformen, auf denen die Inhalte später verbreitet werden, digitale Informationen verlässlich zu halten, sie gegen unautorisierte Nutzung zu schützen und ein sicheres digitales Umfeld für alle zu schaffen.

Man darf aber nicht vergessen: Bei ihnen geht es um den wirtschaftlichen Wettbewerb. So hat zum Beispiel das Europäische Parlament den sogenannten „EU AI Act“ erarbeitet, in dem die Grundlagen für die Regulierung der KI-Systeme in der EU zusammengefasst sind. Anfang Juli hat auch der Deutsche Bundesrat in einem Gesetzesantrag ein schärferes Vorgehen mit beachtlichen Haft- und Geldstrafen gegen Deepfakes gefordert.

Der Gesetzesentwurf wird nun im Bundestag beraten. Zudem sollen Programme zur Erkennung und Kennzeichnung gefälschter Inhalte und eine zentrale Anlaufstelle für Unternehmen geschaffen werden. Von großer Bedeutung ist es jedoch auch, den allgemeinen Technikverstand bei den Gremien zu fördern, wenn es um Digitalisierung und KI-Technologien geht.

Laut der Studie „The State of Deepfakes 2024“ des Online-Scantools Sensity AI gibt es bereits 2298 Tools für KI-Gesichtertausch, Lippensynchronisation, Gesichternachahmung (die Übertragung von Mimik und Bewegung des Gesichts einer Person auf das Gesicht einer anderen Person) und Erstellung von KI-Avataren. Dazu kommen noch 10.206 KI-Bildgeneratoren. Beeindruckend, oder?